(Windows版)PyTorchでGPUを使えるようにするまでを画像付きで詳細に解説

こんにちは。ふらうです。

今回は、Windows上のPython環境でPyTorchを使う際に、GPUを使えるようになるところまでを解説していきます。

今回想定している環境は、GPUがついているPCで、実行環境はWindows版Anacondaを使っている場合です。理由は、私のブログで推奨しているやり方がこれなので、こちらに合わせていきます。

WSLを使ったubuntuの環境では、違った導入方法になりますのでこの記事はほとんど参考にはならないでしょう。

ですが、wslを使わない環境であれば共通する点はいくつもあるので、参考にしていただければ幸いです。

Windows版Anacondaの環境構築の記事は、以下のリンクより閲覧してください。

画像付きで、できるだけ詳細にご案内しますので、最後までお付き合いください。

PyTorchのインストール

まず、PyTorchのインストールを行います。

以下のリンクからPyTorch公式にアクセスします。

そして、少しだけ下に行くと次のような画面があると思います。

ここで、以下のように設定します。

- PyTorch Build ... Stable(1.13.1)

- Your OS ... Windows

- Package ... pip

- Language ... Python

- Compute Platform ...自分に合うCUDAバージョン

今回は、CUDAのバージョンを11.6としました。

もし、あなたのwindowsがwindows11ならば、古いCUDAだとwindows11に対応してない可能性があるので調べてみて下さい。

ここまで選択すると、下の青丸で囲った"Run this Command"の欄に、自分の環境にあったインストールコマンドが表示されます。

これを、Anaconda Promptに貼り付けて実行します。

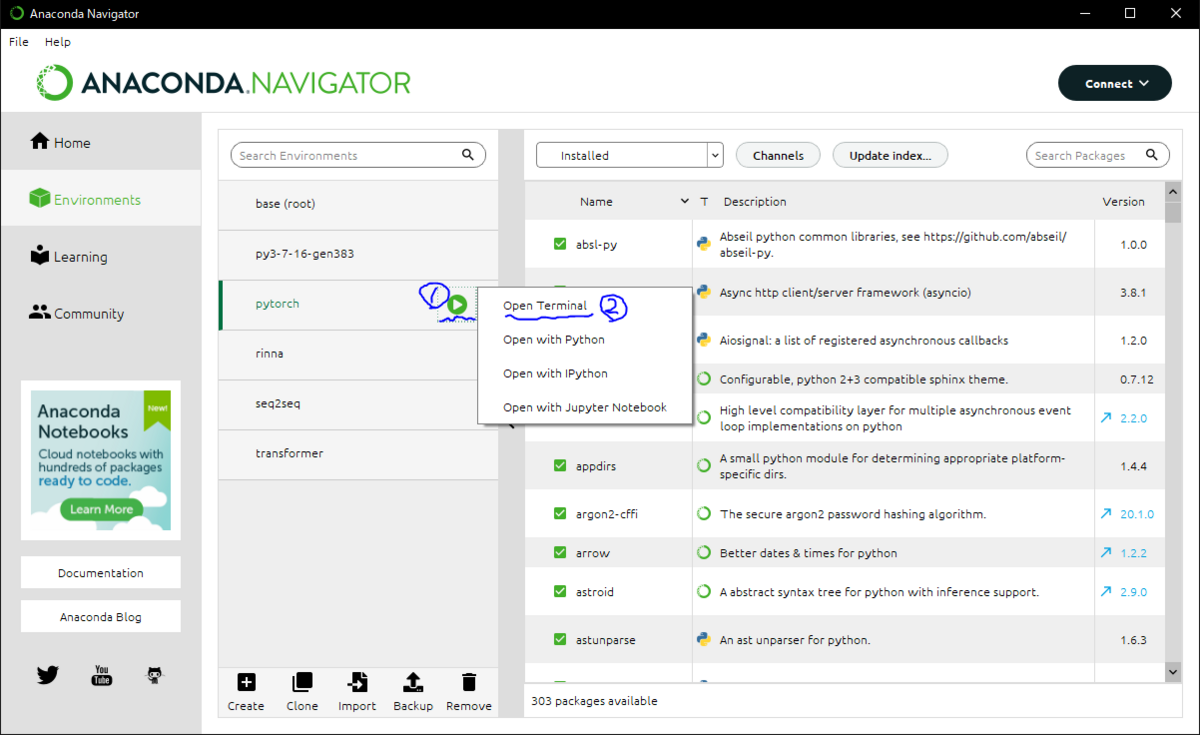

まず、Anaconda Navigatorを開いて、PyTorchを使いたい仮想環境に切り替えます。

私の場合は、pytorchという名前の仮想環境を作って、そこで実行します。

次にターミナルを開きます。

仮想環境名の横にある三角形をクリックした後、"Open Terminal"をクリックすればターミナル(Anaconda Prompt)が立ち上がります。

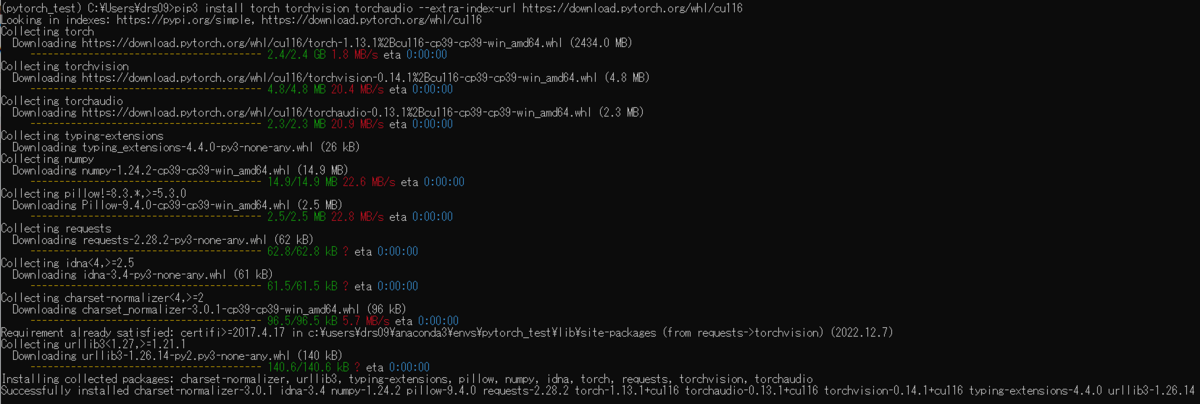

そしてそこに、先ほどの"Run this Command"覧のコマンドを一字一句間違えずに入力してください。(コマンドを範囲コピーして、ターミナル上で右クリックするだけでも貼り付けできます)

![]()

そしたら、Enterを押して実行して、インストールが終わるまで待ちます。

その後エラー表示がなく、画像の最後の行のように、"Successfully installed..."と出ていれば成功です。

これで、PyTorchのインストールは完了です。

CUDA Toolkitのインストール

次に、CUDA Toolkitをインストールします。

以下のリンクより、公式にアクセスしましょう。

ここで注意なのですが、今後Visual Studioを使いたい場合、このCUDA Toolkitより先にインストールしておかないといけないらしいので、Visual Studioを今後使う予定がある方は先にインストールをしてください。

※Visual Studioはプログラムの統合開発環境で、UnityでC#のコードを書くときや、Pythonのプログラムを書くときなど多岐にわたって使われているものです。

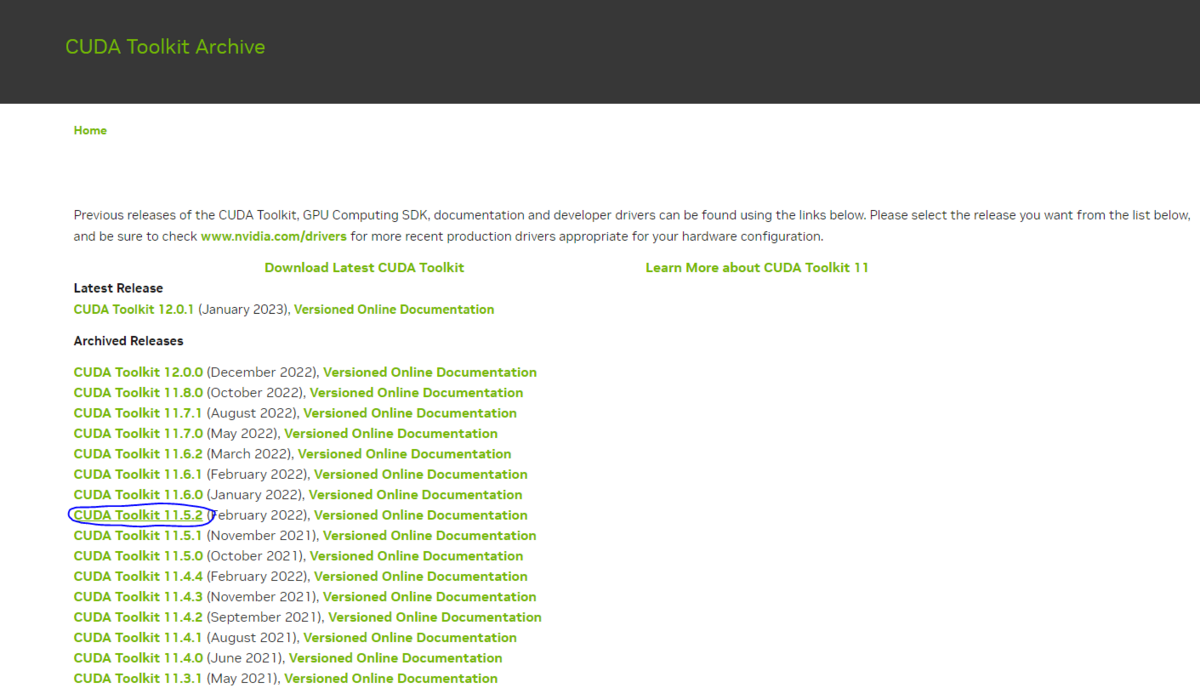

ここから、PyTorchに合うCUDA Toolkitをインストールします。

私の場合は少し古いのですが、CUDA Toolkit v11.5をインストールしてます。

最新版でも動くと思うので、v11.6でも、v11.7でも、v12.0でも何でもいいと思います。

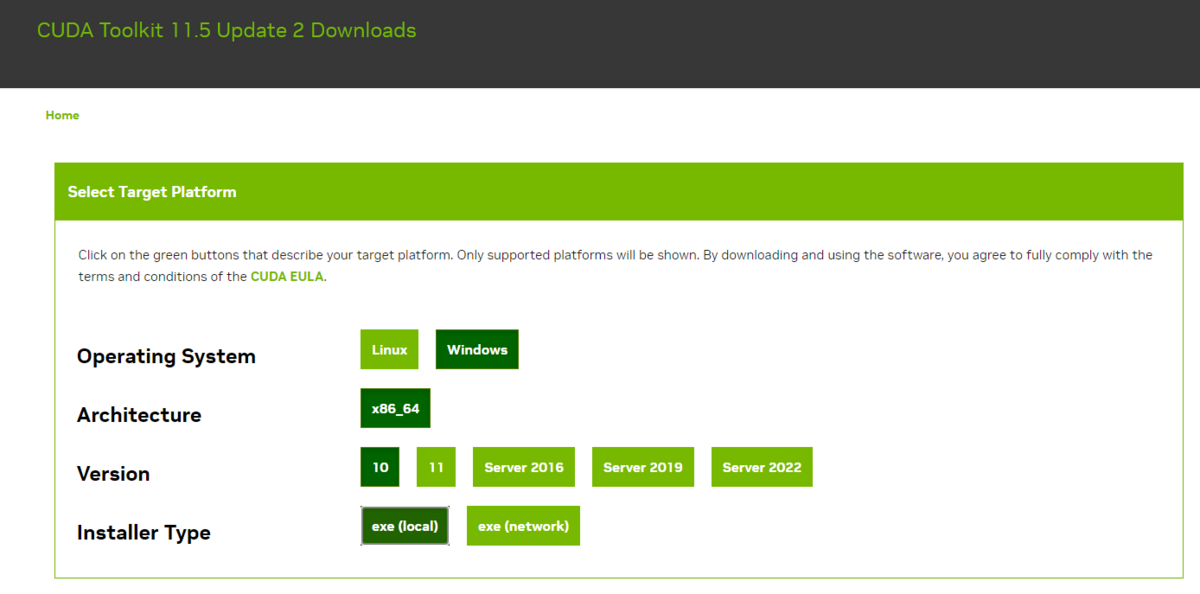

インストールしたいバージョンの部分(青丸)を押した後に自分の環境の選択画面が出るので、選択していきましょう。

今回の場合は、

- Operating System ... Windows

- Architecture ... x86_64

- Version ... 10(windows11を使っている方は"11"にしてください)

- installer Type ... exe(local)

にしてます。

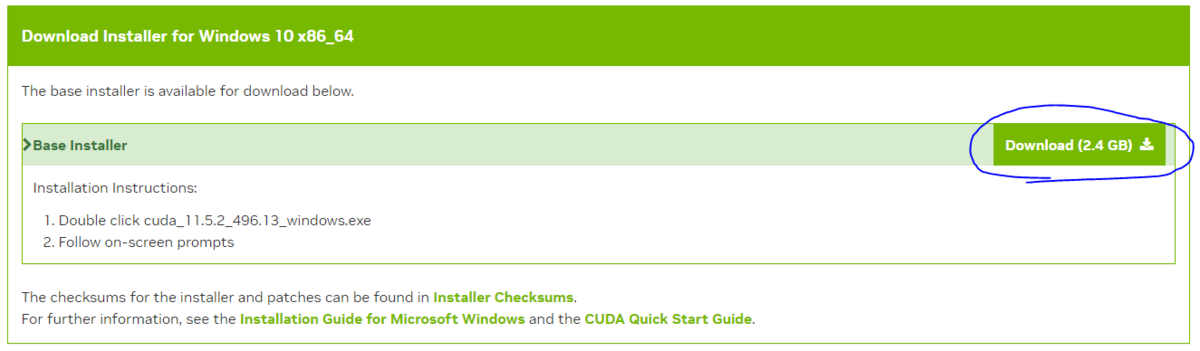

すると、画面下部に以下の表示が出るので、"Download"をクリックしてダウンロードします。

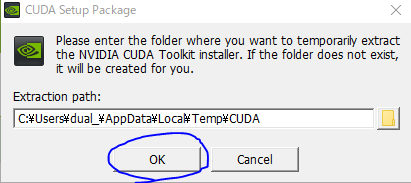

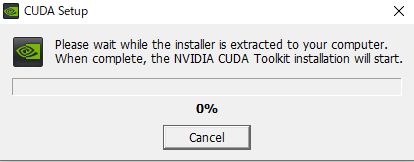

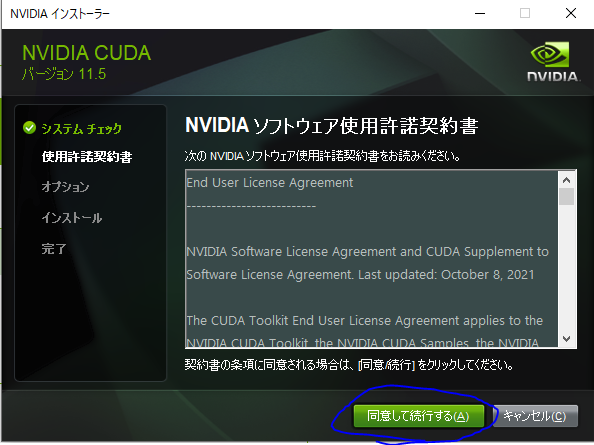

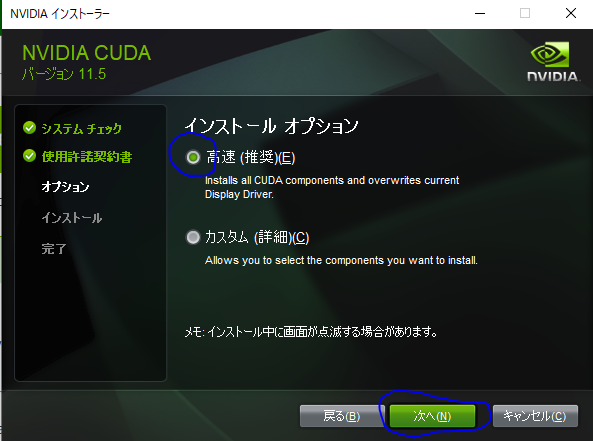

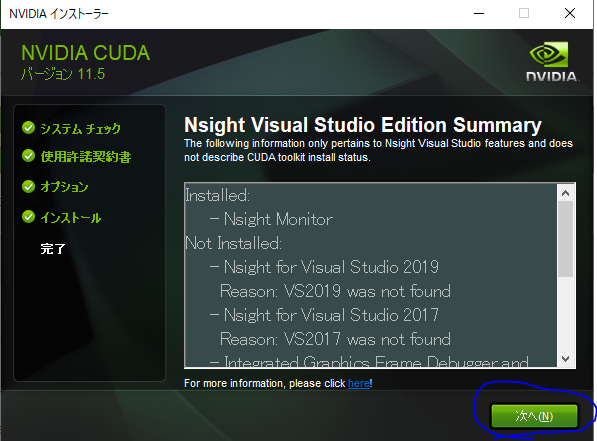

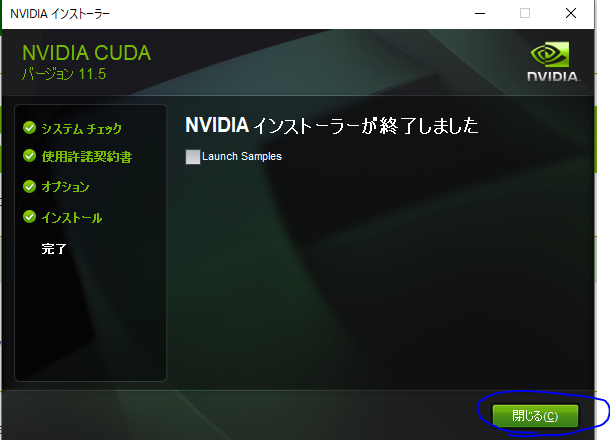

そのexeファイルを実行すると、CUDA Toolkitのインストールの案内が開始されます。

以下の画像の青丸の部分をクリックしていけばインストールができます。

これでCUDA Toolkitのインストールが完了しました。

NVIDIAドライバのインストール

次に、NVIDIAドライバをインストールします。

先ほどインストールしたCUDA Toolkitのバージョンに合うように入れていかなければいけませんが、基本的に最新版でも大丈夫です。

例えば、先ほど私がインストールしたCUDA Toolkit v11.5.2は、NVIDIAドライバのバージョン496.13に対応しています。これは、先ほどダウンロードしたCUDA Toolkitのファイル名

"cuda_11.5.2_496.13_windows.exe"

の赤文字の部分に対応しています。

ですが、最新版のNVIDIAドライバでも、ほとんど問題なく動きますので最新版を入れていきます。

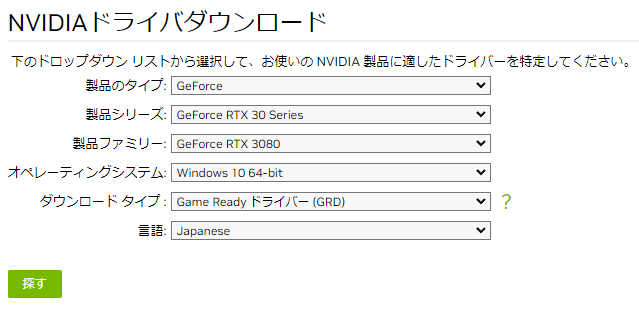

まず、以下のリンクからNVIDIA公式にアクセスし、ドライバをダウンロードします。

ここで、自分の使っているGPUにあった情報を選択しましょう。

私の場合は"Geforce RTX 3080"を使っているので以下のように選択します。

選択したら、左下の"探す"を押してドライバを検索しましょう。

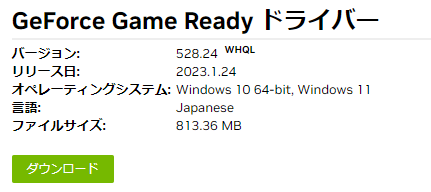

すると、2023/02/07時点では、このドライバが表示されました。

なので、左下の"ダウンロード"からドライバをダウンロードします。

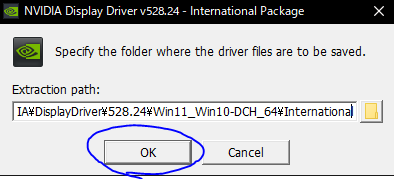

そして、exeファイルがダウンロードされたら、実行します。

"Extraction path"は変更せずに"OK"を押します。

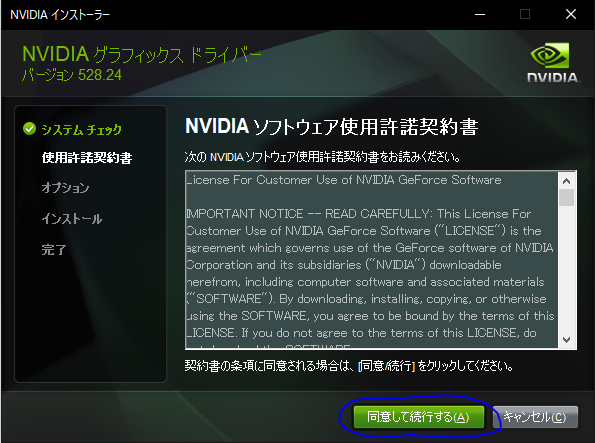

この作業が完了すると次の画面になります。

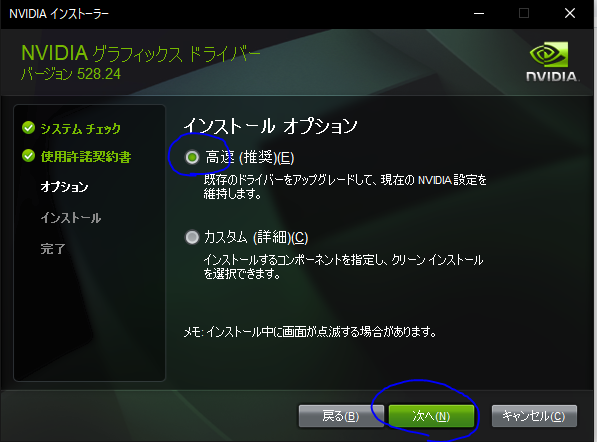

ここから、青丸の部分を選択していってください。

ここまでくると、インストールが始まるのでしばらくお待ちください。

この後"インストールが終了しました"と出れば完了です。

うまくインストールできたか確認

これでインストールが完了しましたので、以下の4つを確認します。

- CUDAのバージョン確認

- PyTorchが使えるか確認

- PyTorchのバージョン確認

- PyTorchでGPUが使えるか確認

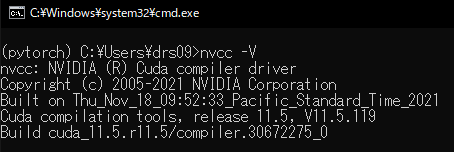

CUDAのバージョン確認

PyTorchのインストールコマンドを入力したときと同じように、PyTorchをインストールした仮想環境で以下のコマンドを実行します。

- "nvcc -V"

このような表記が出れば、CUDAがインストールされています。

先ほどの説明では、私の場合はCUDA11.5を入れているので、最後あたりの部分が"cuda_11.5"となっていますね。

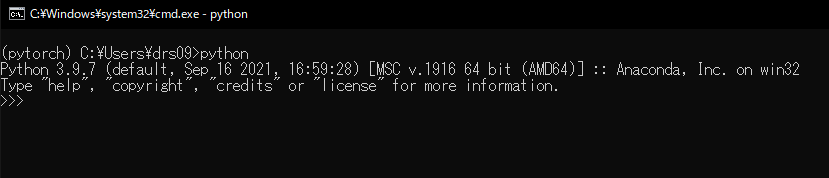

PyTorchが使えるか確認

まず、Pythonの対話モードを起動します。以下のコマンドで対話モードを立ち上げてください。

- "python"

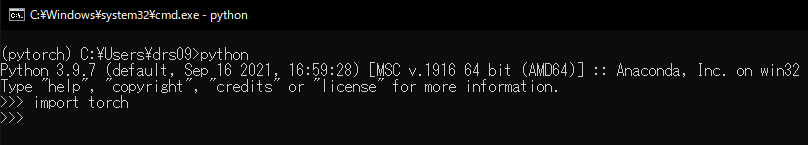

そこで、以下のコマンドでpytorchをインポートしてみる

- "import torch"

ここでエラー無く、画像のように次の3個の矢印が出れば成功。

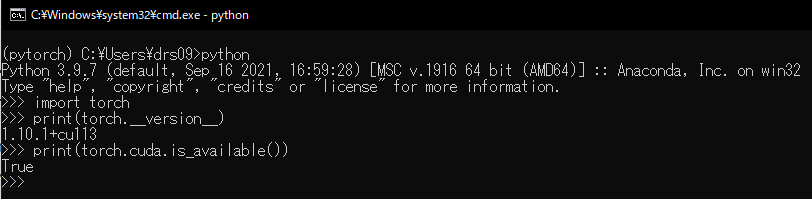

PyTorchのバージョン確認

次にPyTorchのバージョンを確認します。以下のコマンドを実行してください。

- "print(torch.__version__)"

画像のように

"@.@@.@+cu***"

というような表記が出ればOKです。

最初の数字はPyTorchのバージョンで、後のcu以降はPyTorchのCUDAのバージョンです。

なので、上の例では

PyTorchのバージョン ... 1.10.1

PyTorchのCUDAのバージョン ... 11.3

※これはPyTorchに付属しているCUDAのバージョンであり、実際にインストールしたCUDAのバージョンとは違うため注意

PyTorchでGPUが使えるか確認

最後にGPUが使えるかどうかチェックします。

以下のコマンドを実行してください。

"print(torch.cuda.is_available())"

ここで"True"と返ってくればGPUが認識されていて使える状態にあります。

終わりに

最後まで見ていただきありがとうございました!

自分のPCでAIを学習したり構築するのにGPUは必要かと思いますので今回解説させていただきました。

私自身、環境構築にかなりの時間を取られてしまって、なかなかGPUを認識してくれない問題が解決できなかったので、できるだけ誰が見てもわかるよう画像を多めに使って工夫しました。

しかし、まだ説明不足な点もあるかと思いますので、何かご質問があればコメントの方していただければ返答いたしますので、何卒よろしくお願いします。

今回GPU使用環境の構築を行いましたが、ほかにもAIをインストールして遊んでみるようなことをやっておりますので、ほかの記事も見ていただければ幸いです。